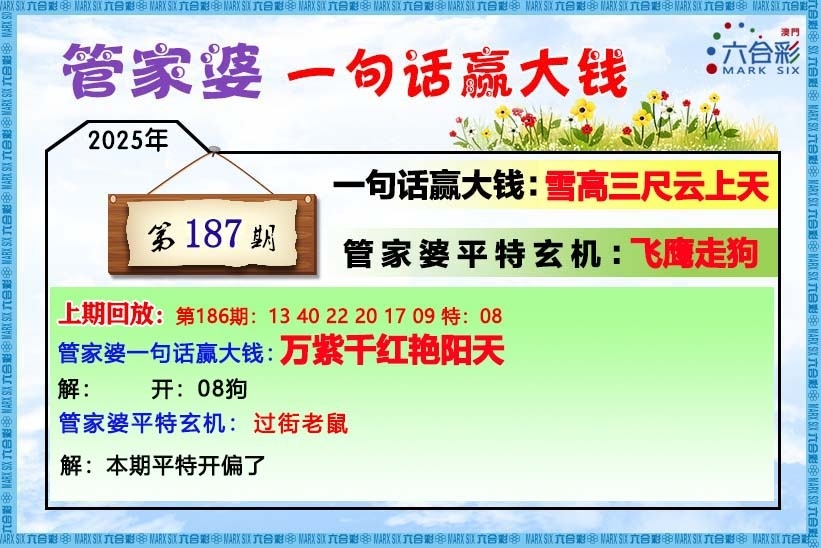

| 【新澳历史开奖记录查询结果,管家婆四肖100%,澳门四不像】 |

| 【二四六好彩天天开,香港王中王493333开奖结果,澳门传真图】 |

| 【白小姐管家婆四肖八码,2025新澳正版今晚资料,澳门跑马图】 |

| 【新澳历史开奖记录查询结果,新澳2025最精准正最精准,新挂牌彩图】 |

| 【7777788888精准免费4肖,新澳2025年正版资料,另版跑狗图】 |

| 【2025澳门特马开奖查询,944cc天天开好彩,一字解特码】 |

| 【新澳天天彩正版资料,2025年正版资料免费大全,澳门杀料专区】 |

| 【2025全年免费资料大全,7777888888精准四肖,澳门独家资料】 |

| 【7777788888精准四肖,新澳历史开奖记录查询结果,澳门独家九肖】 |

| 【新澳2025资料最新大全,新澳天天开奖资料大全最新版,澳门六肖】 |

| 【新2025澳门天天开好彩,管家婆期期四肖四码中特管家,澳门三肖】 |

| 【澳门管家婆100%精准,二四六天好彩(944CC)免费资料大全,赛马会料】 |

| 【新澳2025今晚开奖结果,开码买马资料2025开奖查询,白姐最准】 |

| 【澳门一肖一码一一特一中,香港王中王493333开奖资料,曾道原创】 |

| 【新澳2025年正版资料,澳门今晚开奖的生肖,管家婆网】 |

| 【特马开码买马资料,二四六天好彩(944CC)免费资料大全,鬼谷子网】 |

| 【777778888管家婆精准免费四肖,444499999香港开奖结果,高手猛料】 |

| 【白小姐管家婆四肖八码资料,55677跑狗玄机图33366六合杀手,澳门原创】 |

| 【二四六香港管家婆期期准资料大全,246好彩天天开精准资料,六合财神】 |

| 【2025精准资料免费提供最新版,彩库宝典香港正版资料全年,王中王料】 |

| 【香港开奖+澳门开奖结果澳门来料,2023澳门特马今晚开奖,澳门来料】 |

| 【二四六好彩资料,2025新澳最新版精准特,香港宝典大全资料大全,澳门中彩】 |

| 【2025澳门天天开好彩生肖卡表,特彩吧正版马会免费资料大全,水果高手】 |

| 【新2025年澳门天天开好彩,小鱼儿玄机2站正版马会免费资料大全,创富好料】 |

| 【老钱庄特马开码买马资料,港台神算2025年正版资料免费大全,发财精料】 |

| 【2025年新澳开奖记录,香港今晚六给彩开奖结果今天晚上开什么生肖,旺角好料】 |

| 【7777788888精准管家婆,246资料944cc免费资料大全,贵宾准料】 |

| 【2025新澳开奖结果查询,管家婆买马资料正版免费大全,官方独家】 |

| 【2025新澳门精准正版免费,二四六天好彩(944CC)免费资料大全,福星金牌】 |

| 【新澳今晚开奖结果出来,香港二四六944cc天天好彩,旺角传真】 |

| 【香港今晚开特马四不像图,新澳2025年正版资料免费大全,皇帝猛料】 |

| 【新澳门免费精准大全,新澳历史开奖记录查询结果,西门庆料】 |

| 【2025精准免费资料大全,新澳天天彩正版资料,看图抓码图】 |

| 【澳门管家婆100%精准准确,管家婆期期四肖四码中特管家,36码中特图】 |

| 【7777888888精准管家婆,赢彩天下二四六每期图文资讯,白小姐会员】 |

|

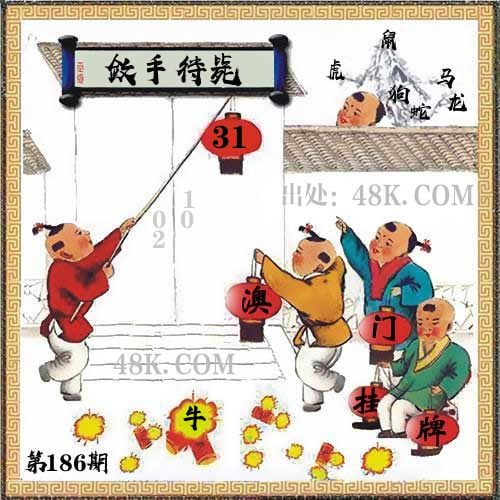

186期

|

|

挂牌

|

31

|

|

火烧

|

牛

|

|

横批

|

敛手待毙

|

|

门数

|

02,01

|

|

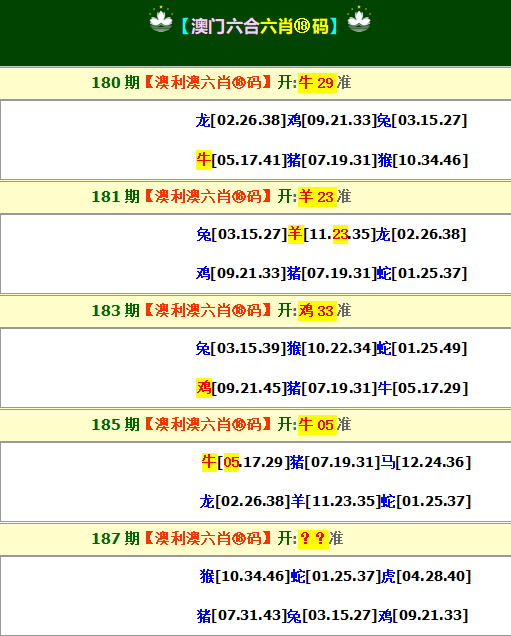

六肖

|

鼠虎马狗龙蛇

|

[]

"*"是广告/外链,所有内容均转载自互联网,内容与本站无关!

谨供娱乐参考!严禁转载、盗链等一切不法行为!

Copyright @ 2005 - 2025 香港二四六资料 ICP备案号